株式会社stu (左から)今村理人氏、すぎのひろのり氏、高尾航大氏

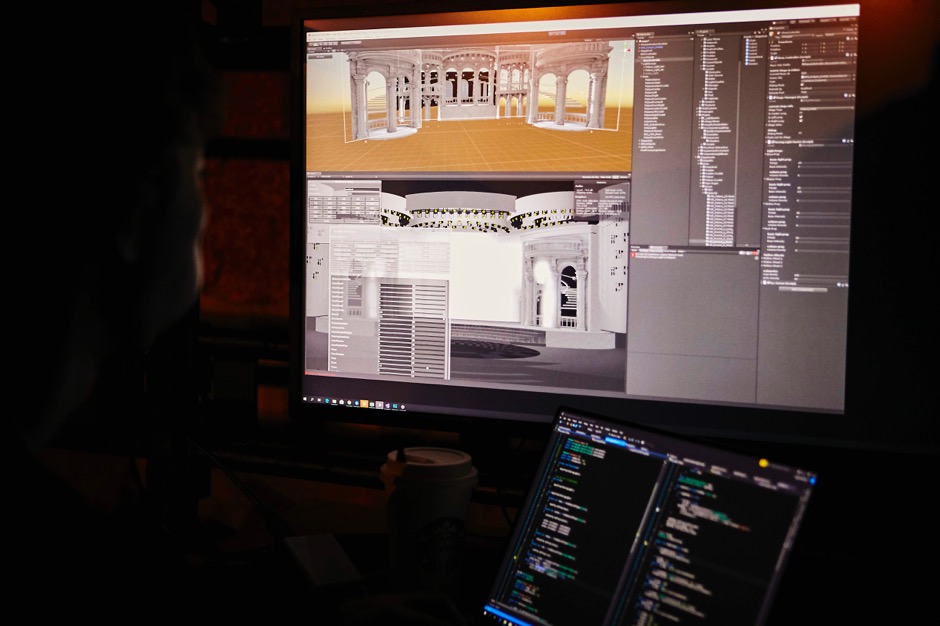

『NHK紅白歌合戦』といえば日本の大晦日の風物詩。2018年12月31日に行われた『第69回NHK紅白歌合戦』では、数多のビッグネームのアーティストたちが、それぞれの世界観でパフォーマンスを行った。生放送で、これだけ多くのアーティストが異なる世界観のパフォーマンスを実現させるとなると、実際の舞台転換では間に合わない。そこで採用されたのが、ステージ美術を映像で代替するシステムだ。Unityをベースにした映像空間によって、実空間と映像空間を馴染ませることで、リアルとバーチャルの境界線の区別がつかないほどの演出を実現した。

その演出を手掛けたのが、今村理人氏、すぎのひろのり氏、高尾航大氏ら株式会社stu。今回はプロデュース・舞台美術を手掛けたNHK デザインセンター 映像デザイン部の服部竜馬氏とともにお話を伺った。

まず、NHKと株式会社stuがコラボレーションするきっかけからお教えください。

服部竜馬(以下服部)

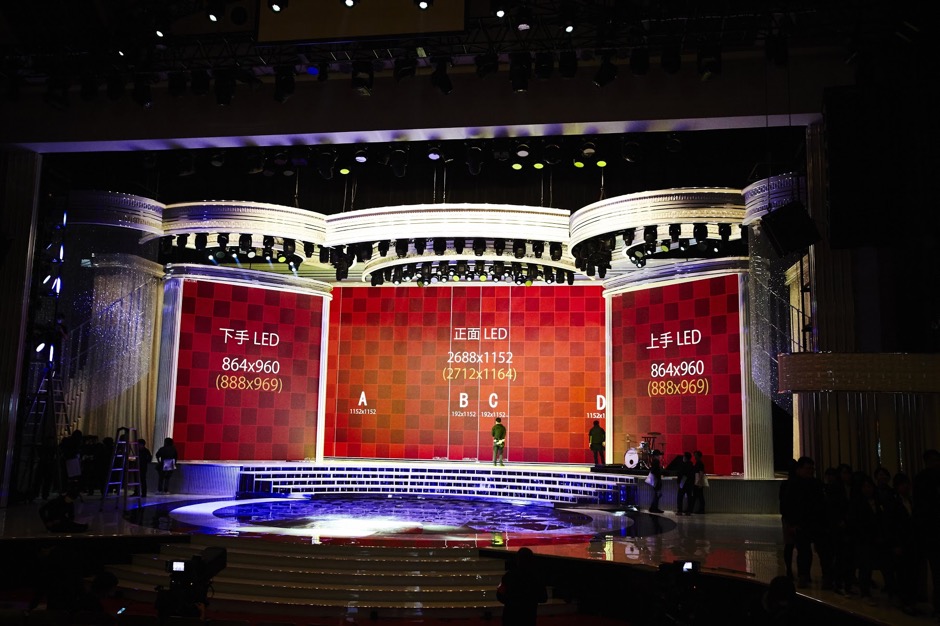

stuさんにいる方々が開発を手掛けた「DMM VR THEATER」という劇場にアートネット信号で映像のライティングコントロールをするシステムがあったことを聞いていて、今回ぜひご一緒したいということでご相談させていただきました。そもそも『NHK紅白歌合戦』には「NHKホールで行う」という、決められたスケールで物理的な制約がある中で毎回全く違う世界を見せなくてはならない、という大きな縛りがあるんです。それを、Unityのようにそうした場で強みを発揮するプラットフォームを介してインテグレートしたいというのが最初のアイデアでした。

服部竜馬氏

70回近くやってきている中で、毎回異なる世界観を作っていかなくてはならないと。

服部

これまでは巨大なLEDスクリーンを使ってきましたが、そこから先に進んで、リアルなステージにあるセットと、LEDや照明などがシンクロすることでステージの上に別世界が広がっているような表現をしたいと考えたんです。

今村理人(以下今村)

そこで作ったのがUnityを使った「シンクシステム」です。照明信号と、電飾信号を受けてUnity内でリアルタイムにコントロールする仕組みですね。

服部

以前は、本番数日前に作られたキューシートを元に照明や電飾を操作して、リハーサルでその動きを合わせていました。ですが、現場は生物ですから、パフォーマンスの精度に合わせて演出を変えていくとなると、プリレンダリングの映像が置いてけぼりになってしまうんですね。「シンクシステム」だと、ギリギリまで一緒に調整できるのが画期的でした。

今村

実際に組まれたセットと、Unityのバーチャル空間を組み合わせてみると、我々が見てもどこからがバーチャル空間なのかわからないくらいリアルに見えます。そもそも、コンサートツアーのデザインや照明の設計というものを全部キャリブレーションするとなると、プリレンダリングで調整していては間に合わない。それが、Unityを使うことによって、LEDの映像と照明のキューのタイミングを合わせて、ムービングライトがギュンッと反応するようなダイナミックな演出が可能になったんです。

そもそも、株式会社stuはどのような会社なのでしょうか?

今村

stuという文字は、アルファベットでVとRの間にあるんです。リアルとバーチャルを横断的にまたいでクリエイティブを形にする組織として命名しました。すぎのさんはチームラボ在籍時からこの界隈では有名人でしたが、以前からお仕事でも何度か付き合いがあったのですが、昨年4月にテックとデザインを両立させるハイエンドなクリエイティブチームとしてstuという会社を作る話が立ち上がった時、コアメンバーとして僕より少し先にコミットしていたメンバーの一人がすぎのさんでした。彼がいれば確かにこういった技術的にも難易度の高いプロジェクトを実現する身体能力が高いチームにできるという確信を持って、まさに今そういう形で走り続けている所です。

高尾さんは僕が元々注目していたVR方面の若手クリエイターの中でダントツに優秀なクリエイターだったんですが、昨年夏にお願いした輝夜月のVRライブをはじめとしたクリエイティブエンジニアリングが素晴らしくて、紅白をきっかけに正式にメンバーになっていただきました。

stuが手掛けた『TWICE DOME TOUR 2019 #DREAMDAY』

『NHK紅白歌合戦』といえば日本中が注目する一大コンテンツですが、プロジェクトが始まったのは?

今村

おそらく2018年の9月か10月の頭くらいにお声がけ頂いてそこからスタートしたので、実質的な開発期間は2ヶ月くらいですね。

すぎのひろのり(以下すぎの)

僕たちとしても、生放送は初めての経験でした。

関わったスタッフは何人ですか?

今村

stuのチームは5、6人ですね。

服部

NHKのチームも、デザイナーが6人です。

驚くほどの少人数ですね!NHKがセット自体を設計し、そこにstuがUnityでバーチャルな要素を加えていったということですね。今回初めてリアルタイムでの試みということで手探りで制作を進めていった面もあるのではないでしょうか。

服部

NHKサイドでは、「LEDの中をこういう空間にしたい」いう要件をある程度固めてからstuさんに実装をお願いしました。そもそもセットをデザインする段階では、アナログもバーチャルも関係ないんです。電飾のデバイスを何本どこに埋め込んで、どういうチャンネルを振り分けて、という部分はどちらにしろ必要なので。

演出では100台以上のムービングライトを使ったそうですから、設計の段階でもかなりの苦労があったでしょうね。

服部

実際に仕込むムービングライトにはたくさんの機種があって、それぞれ特性があるんです。ビームの伸び方、フォーカスや輝度が違ってくるので、こちらが求める表現が可能になる条件を照明さんに汲んで頂いて、販売されている商品の中から組み合わせて理想とするシステムを作り上げてもらうというチャレンジをしています。映像の方でもGPUの制約がありますが、電飾でも送出できるチャンネル数など制約があるのは同じこと。そこはすぎのさんと照明担当が話してすり合わせをしながら作っていった感じですね。

照明の職人技とバーチャルテクノロジーのぶつかり合いのようですね。

すぎの

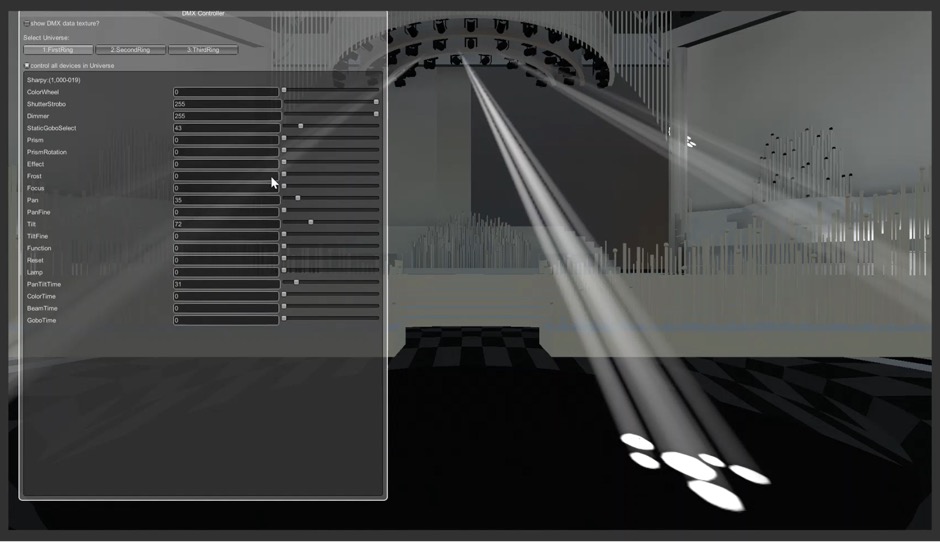

実際に、実機を2週間くらい貸してもらったんです。逆に言えば、たった2週間で照明の動き方を把握して実装しなければならなかったので若干大変でしたが(笑)。今回はメインで使ったムービングライトはsharpy他全部で3種類です。

あれだけ大舞台で使うムービングライトとなるとテストするのも一苦労だったのでは…?

すぎの

テストはオフィスでやったんですよ。ムービングライトのスペック表を見ると「40メートル離したところに投影してください」なんて書いてあるので下手に扱うと危ない(笑)。なので、できるだけ光の強さを調整しながら、燃えなさそうな素材に打っていました。操作をミスしてしまうとめちゃくちゃ眩しかったりして…。

照明設計

すぎのさんの方ではどのようなシステム設計を行っていったのですか?

すぎの

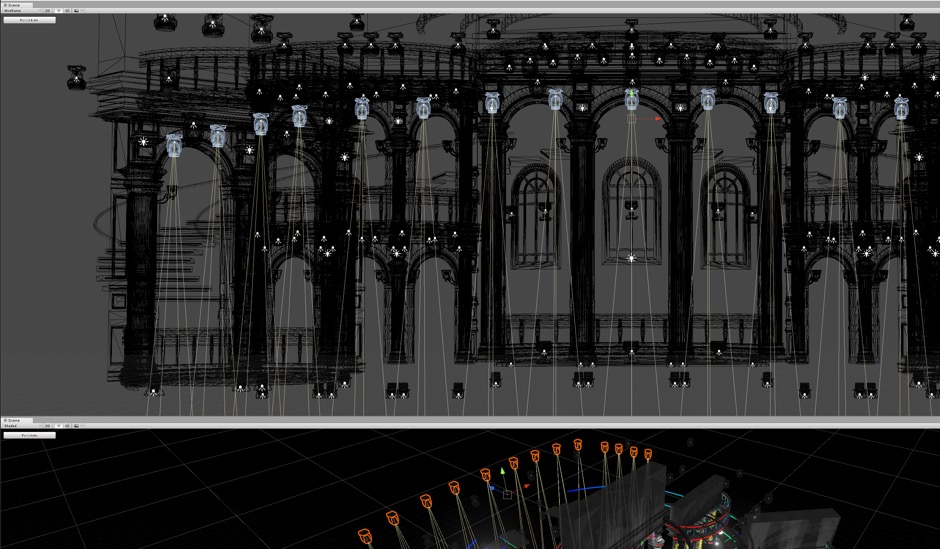

舞台では基本的にアートネットというDMXをネットワーク経由で送る信号が使われていたので、それをブロードキャストで、実際の照明灯体やLED電飾に送りながら、Unityにも同じ信号を受けて、バーチャル上の映像を動かす仕組みを作りました。とはいっても、プログラムで信号を送ってから1秒後に動くように作ったところで、実際の照明塔体の方での再現率が均一でなかったりするので、変数を入れつつ微調整していきました。

服部

単純にムービングライトのヘッドを動かすだけでも、スペック表には書いていないカーブがかかっていることがあるんです。さらに個体差もありますから、散らしていかないと動きが揃いすぎて気持ちが悪くなってしまうんです。

100台分手で調整していったんですか…?!

すぎの

流石に実際は1台分を作って、あとはコピーしました。Unity上では、ボリュームレンダリング的なビームが標準ではないので、アセットストアで探しました。すごくパフォーマンスが良いものがあったんですが、照明灯体のゴボ(光に形をつける機能)が再現できなかったんです。

最終的にはどのように解決されたんですか?

すぎの

いろいろなアセットを試した結果、一番良かったのが「Hx Volumetric Lighting」です。ただ、通常のボリュームライトの仕組みは木漏れ日のゴッドレイや雲の隙間の光を表現するために作られているので、そのままだと真っ平らに見えてしまうんです。

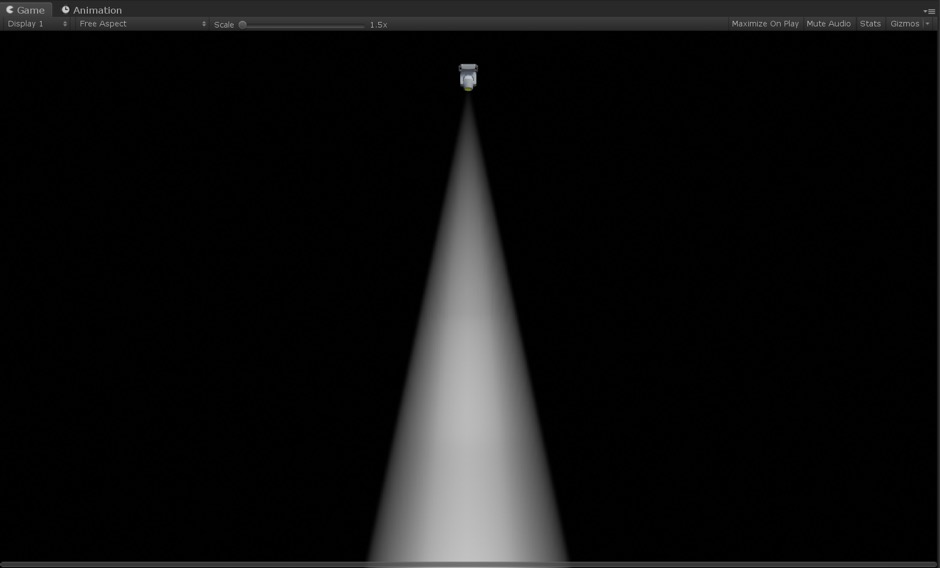

シェーダでの書き換え前

光の減衰が発生しないんですね。

すぎの

ずっと一定の光の強さになっているので、照明演出で必要とされる、光源の近くでは明るくて離れると暗くなるという表現が出来ない。そこの部分は自分でシェーダを書き換えて、ちゃんと光がドラマチックになるように実装しました。かなり見え方が変わりましたね。

調整後

服部

劇的に見え方が変わったんですよ。それまではペラペラに見えていたものに、立体感が出て。その時点で12月20日くらいだったので、こちらは焦っていたんですが、すぎのさんだけは落ち着いていて「大物だ」と思いました(笑)。

ステージ演出で重宝されると思うので、ぜひアセットとして出して頂きたいです。

今回、多層的な映像を展開されていますよね。その部分はどうやって作られたのでしょうか。

今村

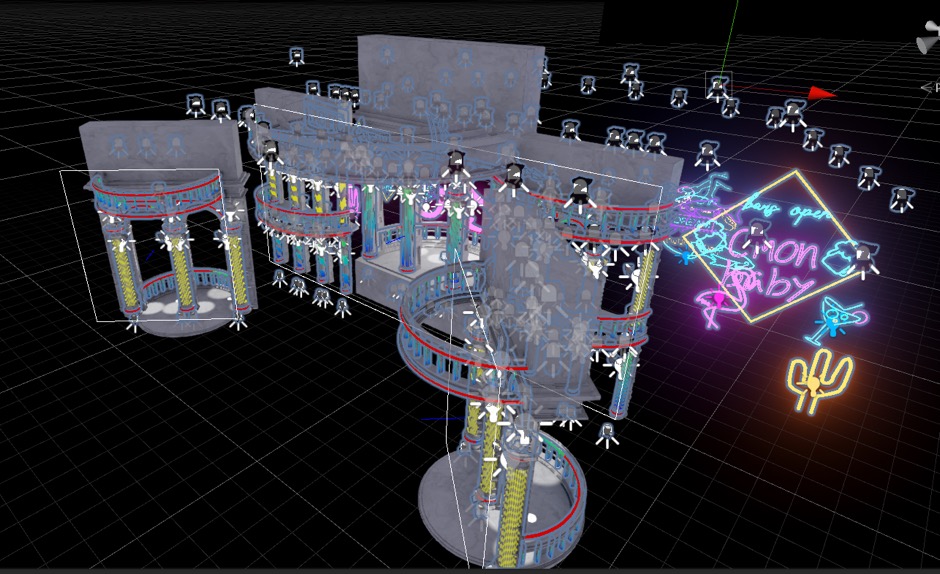

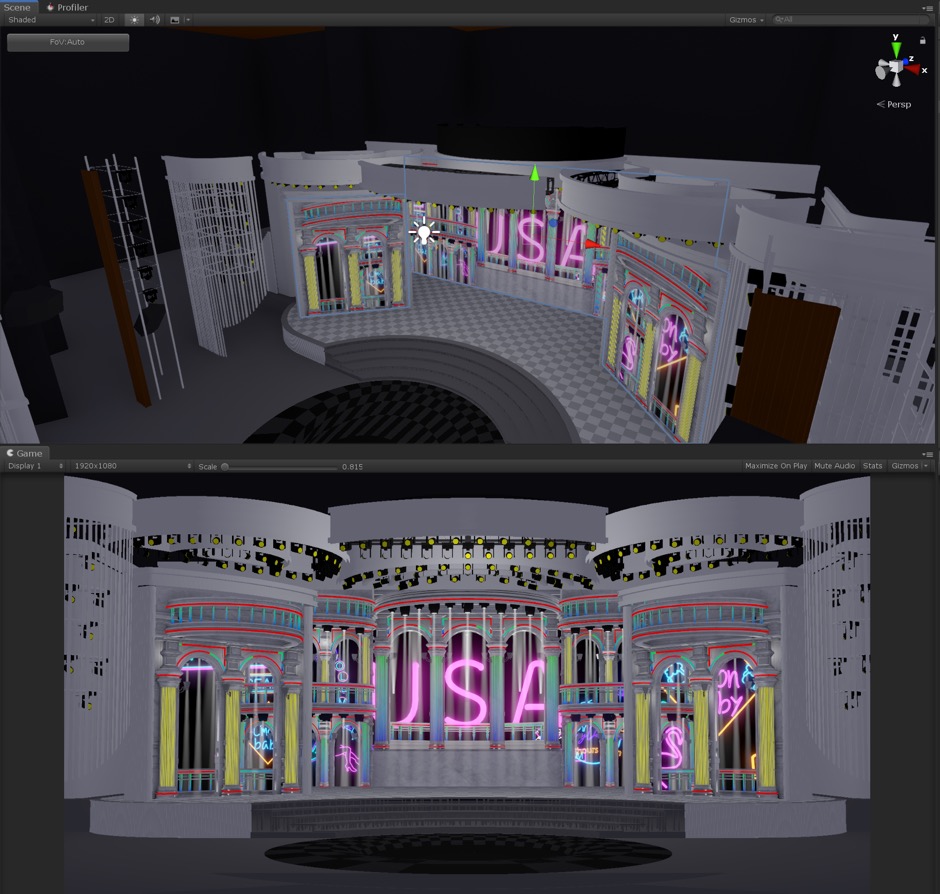

今回は制作の人数が少ないので、作業を切り分けできる仕組みを作りました。Unity上でパレス(実際のセット)の後ろに空や夜景などの映像を出すところと、パレスの全面に出す映像を分けて、作業を分離しました。

実際にはどうやって行われたのですか?

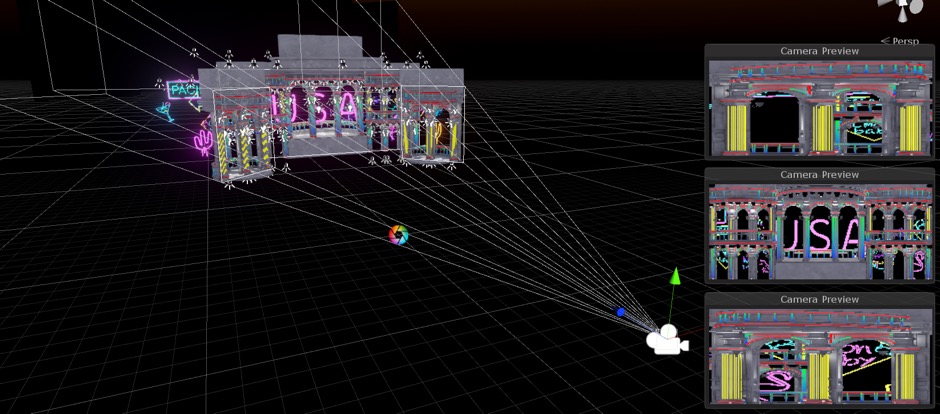

高尾航大(高尾)

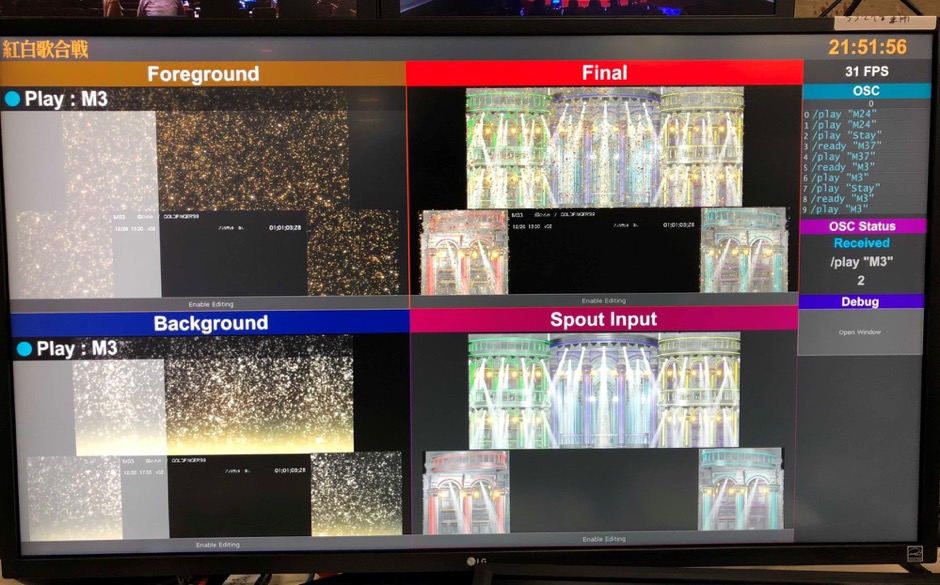

レイヤーを複数作ったんです。まずは建物等の3Dモデルを置いているレイヤー、背景はプリレンダリングの映像、前景がアルファ付きのプリレンダ映像を加算合成しました。背景とUnityのレイヤーはアルファ合成で、一番前だけが加算合成になっている。TouchDesignerの中で前景と借景を同時に再生させて、背景だけUnityに送り、カメラの一番奥にその背景の映像が映るようにして、それをカメラで映した結果をまたTouchDesignerに戻して、前景を加算合成して流すという形にしています。

今村

『NHK紅白歌合戦』では、五十曲以上のパフォーマンスが行われます。そのうち、このシステムを使ったのは半分くらいですね。電飾とムービングライトだけだと、手詰まりになってしまう。それがこの多層的なシステムがあれば、DA PUMP「U.S.A.」のように電飾でバキバキに表現することもできるし、叙情的な風景やスペーシーな演出もできる。そういった多様性を全部受け止められるプラットフォームが最終的に出来ました。いわゆる特効(特殊効果)と呼ばれるものは再現できたと思います。

演出が多くなると、物量も増えるので、データが重くなってしまうのでは?

すぎの

ライトは100体ありますから重いですよ。ライトの向きや点灯している数によって、GPUの負荷が明らかに変わるので、マシンをひたすら強くしました。GeForce RTX 2080 Tiを2つ使って。

高尾

電飾のほうでの対抗策は、極力マテリアルやオブジェクトの数を少なくする仕様に最初から決めたということですね。例えばたくさん色が出るLEDだったら、UVのゼロから1に割り振って、シェーダ側で切り、シェーダ側で色を付けて、エミッションを焚いて、というように。例えば現場で見る電飾とテレビに映る電飾の明るさが違ったりするので、デバッグ用のソフトウェアを開発したりもしていました。最終的に頻繁に使うようになったので、作っておいてよかったです。

その調整はいつ行われたんですか?

高尾

本番の前日ですね。

服部

ステージが完成するのが29日から30日ですから。カメリハから本番までの流れの中で照明や電飾のキューを作っていく。すごく高速に行われる作業です。

リハと本番で、演者さんの動きが変わったために、照明も変えなくては、ということもありますよね。

今村

当然あることです。「ちょっと赤みを足そう」ということがパラメーター一つで出来るのも、Unityの利点ですね。

最終的に、いつまで作っていたのでしょうか…。

服部

当時の午前中までがリハーサルなので、そこまでは調整していました。さすがにそれ以降は、ビルドをしてからは触っていません(笑)。ビルドも10分かからないくらいでしたね。

複数のカメラでのパース合わせ

他にも、テレビならではの苦労として、複数のカメラでパースを合わせるということもあったのでは?

高尾

平行投影で映してしまうと、真ん中のカメラから見たときにズレて表示されてしまうんですよね。そのためにUnity上でCameraの設定にPhysical Cameraが用意されているわけですが、パラメータのが実写に近い描き方になっているので今回はプロジェクション行列を直接編集しました。カメラが動いてもパースが全部合うように付いてきてくれるので、LEDの面がズレたとしても、カメラから見たパースは完璧に合うようにマッチムーブするという機能を作ったので、それがすごく役に立ちましたね。

などなど、語れば止まらないステージにおけるリアルとバーチャルの融合の可能性。2019年9月25日・26日に東京・グランドニッコー東京 台場で行われる「Unite Tokyo 2019」では、今村氏、すぎの氏、高尾氏らが登壇し「ライブエンターテイメントにおけるUnity」をお話する。詳細は「Unite Tokyo 2019」公式サイトにて。